A OpenAI anunciou, nesta segunda-feira (13), o lançamento do GPT-4o, atualização em seu modelo de linguagem GPT-4. A novidade apresenta funcionalidades que a tornam mais versátil e intuitiva, com foco na interação multimodal por meio de texto, áudio e vídeo.

Abaixo, os pontos principais presentes nesta nova versão da ferramenta:

Maior compreensão e interação entre texto, áudio e imagens

- O GPT-4o aprimora a interpretação de textos, áudios e imagens, permitindo uma comunicação mais natural e precisa;

- As conversas em áudio se tornam mais dinâmicas e fluidas, com a capacidade de interromper o modelo e obter respostas instantâneas;

- A latência entre as comunicações foi reduzida pela metade, proporcionando uma experiência mais eficiente.

O vídeo abaixo, oficial da OpenAI, demonstra a interação entre 2 GPT-4os. O vídeo possui menos de 6 minutos

Análise e geração de vídeo em tempo real

- O modelo agora pode analisar e interpretar vídeos da câmera do usuário em tempo real;

- Isso permite a interação simultânea com o modelo, mostrando o que está acontecendo no ambiente e recebendo respostas instantâneas;

- O GPT-4o também identifica sentimentos através das expressões faciais do usuário e reconhece o ambiente ao redor;

- Acessibilidade e API aprimorada:

- O GPT-4o estará disponível gratuitamente para todos os usuários, democratizando o acesso à tecnologia;

- Assinantes dos planos Plus e Team terão acesso a uma janela de contexto 5x maior, permitindo conversas mais complexas e aprofundadas;

- A API do GPT-4o já está disponível, oferecendo aos desenvolvedores acesso aos recursos aprimorados do modelo;

- A API é 2x mais rápida que a versão anterior, 50% mais barata e oferece limites 5x maiores.

Assista abaixo o vídeo oficial de lançamento do GPT-4o. O vídeo possui 26 minutos e traz demonstrações e informações completas das novidades.

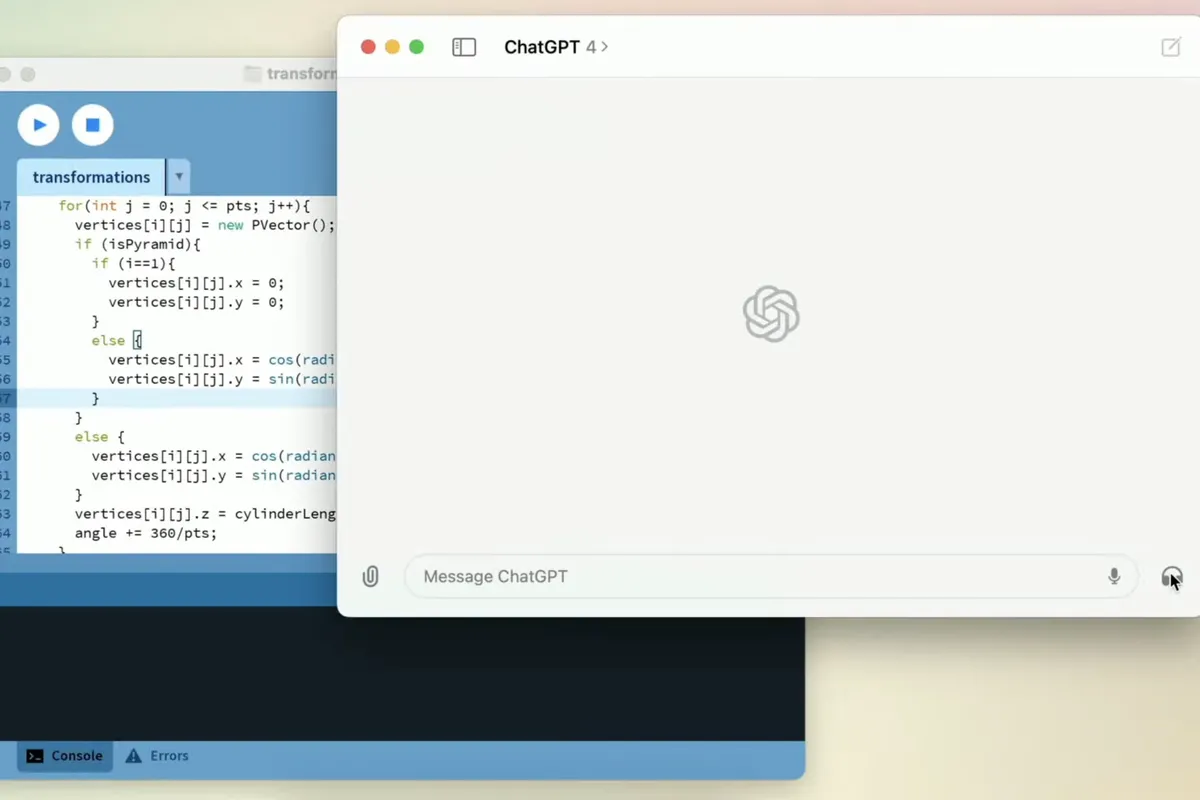

Versão para Desktops

A OpenAI também lançou o aplicativo Chat GPT para Desktop, permitindo que os usuários utilizem o modelo diretamente em seus computadores e interagindo com sua área de trabalho.

Avanço rumo à inteligência artificial geral (AGI)

A Digital Academy destaca a capacidade de interação com vídeo em tempo real, a identificação de sentimentos e as atualizações da API como os principais pontos fortes do novo modelo. A dinâmica das conversas em áudio e o raciocínio do modelo aproximam a interação com a inteligência humana.

A empresa parece estar dando seus primeiros passos rumo à AGI, onde os modelos precisam observar e interpretar o mundo real antes de agir.

Futuro

A OpenAI reconhece que o modelo ainda está em desenvolvimento e que algumas falhas foram observadas durante a demonstração. A companhia acredita que o potencial e as possibilidades do GPT-4o foram significativamente aprimorados em relação ao GPT-4 Turbo. Nas próximas semanas, a promessa é de mais novidades e aprimoramentos.